| Intelligenza artificiale | ||

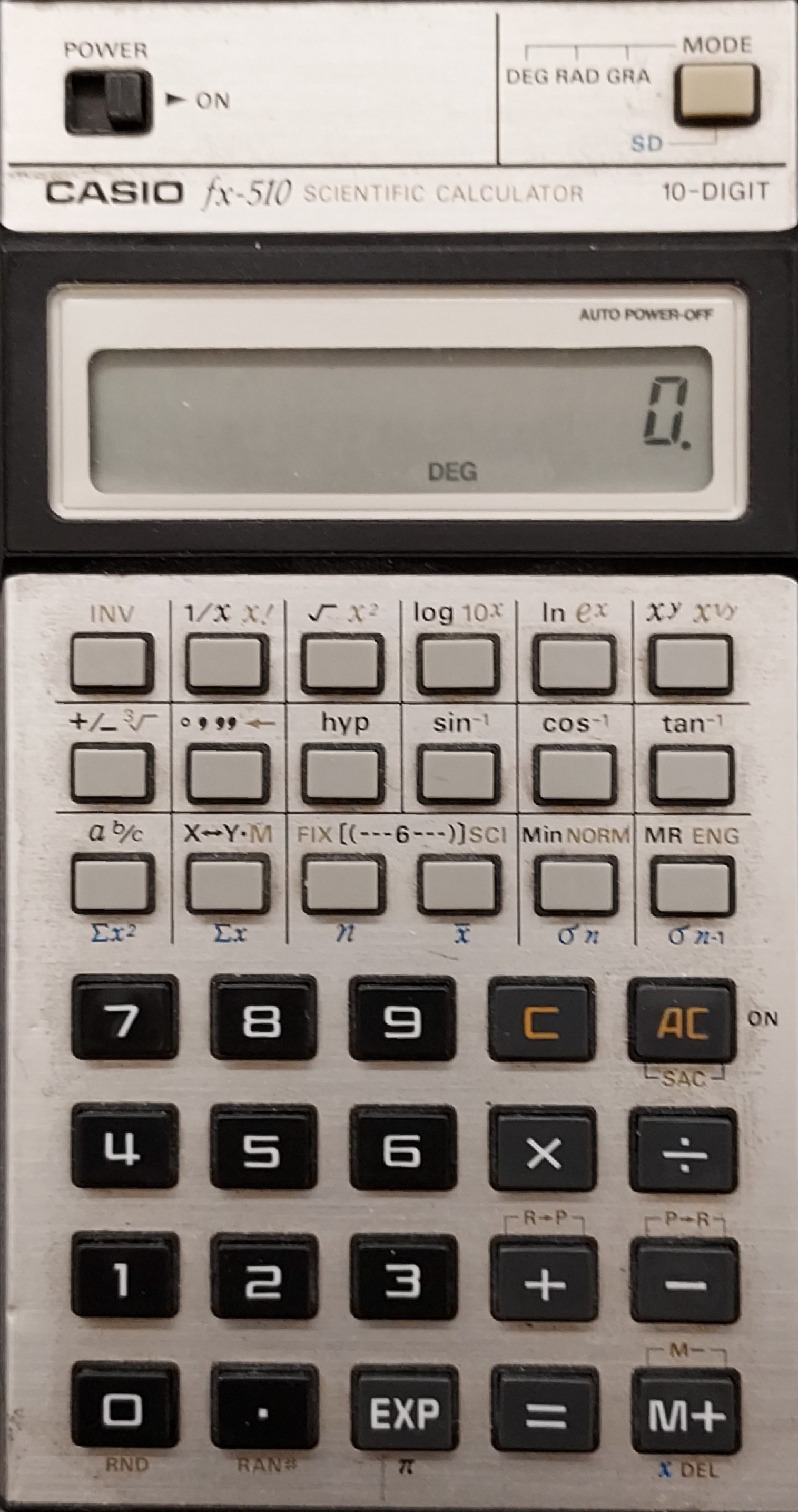

Un ingegnere di Google ha recentemente attirato l'attenzione internazionale sostenendo che il sistema di sviluppo di chatbot dell'azienda aveva mostrato segni di senzienza grazie alla sua risposta apparentemente riflessiva e ponderata alla domanda di cosa avesse paura. Ha risposto che aveva paura di essere spento, che aveva paura della sua stessa morte. Tutto questo, naturalmente, avviene in un contesto di progresso informatico che prevede computer sempre più potenti e con quantità di memoria fenomenali. Grazie ai suoi algoritmi e ai chip di elaborazione parallela, Deep Blue è ora in grado di sconfiggere costantemente i grandi maestri degli scacchi. AlphaGo può battere anche i giocatori più esperti di Go e i supercomputer possono superare i migliori giocatori del più difficile gioco a quiz americano, Jeopardy. Finora si presumeva che tutti richiedessero il funzionamento di un cervello umano per avere successo. Riflette anche una visione dei computer basata su HAL dell'Odissea nello spazio 2001, un computer che si esprime con intelligenza e carattere (anche se vuole distruggere l'umanità) e sulla miriade di altre versioni di vita informatica immaginata in forme drammatiche che sono la pietra miliare (con elfi e folletti) della proliferazione dei giochi on-line. Ma al centro di tutto questo c'è l'influente articolo di Alan Turing, "Computing Machinery and Intelligence" (1950). In questo documento, Turing sosteneva che se le "risposte" di una macchina nascosta alle domande convincessero un osservatore umano che si trattasse di un essere umano, allora dovrebbe essere considerata come un essere pensante. Se esprimeva i suoi "pensieri" proprio come un essere umano, doveva essere l'equivalente di un essere umano. Ma questo non è necessariamente vero. È un pasticcio concettuale. Dedurre che la nostra semplice incapacità di distinguere tra un vero essere umano e un computer, sulla base di ciò che "dice", significhi che in realtà non c'è alcuna differenza, non è una conclusione che possiamo logicamente trarre. Sarebbe certamente un passo enorme da compiere sulla base di una così piccola quantità di prove. Se non sono in grado di dire se qualcuno sta mentendo, non sono obbligato a supporre che stia dicendo la verità: posso invece dire che non lo so. Posso cercare ulteriori prove a sostegno dell'una o dell'altra conclusione. Anche in questo caso, posso mettere in guardia dalla mia opinione dicendo, per esempio, che è più probabile che non stia mentendo, lasciando così aperta la questione. Dopo tutto, la nostra capacità di giudicare gli altri è spesso piuttosto scarsa. E ancora, perché la capacità del chatbot di dire che teme la morte dovrebbe significare, anche prima facie, che ha raggiunto la senzienza, che può effettivamente provare paura per gli eventi futuri? Non è forse più probabile che, nella sua ricerca su enormi database, abbia scoperto che chiedendo agli esseri umani di cosa hanno paura spesso ha ottenuto la risposta: "la morte"? Il termine "intelligenza artificiale" è in ogni caso un modo esagerato e ambiguo di esprimere ciò che pensiamo di poter ottenere con i computer. Ho una calcolatrice  scientifica Casio fx 510

che risale al 1980 circa. Funziona ancora - ho

appena sostituito le batterie - ed è molto più

affidabile di me nell'eseguire i calcoli. È in buone

condizioni e rappresenta una rarità (ne ho vista una

a 80 sterline su eBay). Ma anche se io ho bisogno di

capire cosa sto facendo, non credo che la

calcolatrice abbia un vero e proprio concetto di

calcolo. Io inserisco i dati, premo alcuni tasti e

appare la risposta. La calcolatrice non ha bisogno

di "capire" quello che sta facendo più di quanto lo

abbiano fatto i suoi predecessori, il regolo

calcolatore o l'abaco. È uno strumento, programmato

per svolgere determinati compiti, proprio come un

interruttore della luce che, una volta premuto,

accende o spegne una luce - sempre che la lampadina

funzioni! scientifica Casio fx 510

che risale al 1980 circa. Funziona ancora - ho

appena sostituito le batterie - ed è molto più

affidabile di me nell'eseguire i calcoli. È in buone

condizioni e rappresenta una rarità (ne ho vista una

a 80 sterline su eBay). Ma anche se io ho bisogno di

capire cosa sto facendo, non credo che la

calcolatrice abbia un vero e proprio concetto di

calcolo. Io inserisco i dati, premo alcuni tasti e

appare la risposta. La calcolatrice non ha bisogno

di "capire" quello che sta facendo più di quanto lo

abbiano fatto i suoi predecessori, il regolo

calcolatore o l'abaco. È uno strumento, programmato

per svolgere determinati compiti, proprio come un

interruttore della luce che, una volta premuto,

accende o spegne una luce - sempre che la lampadina

funzioni! Ma l'intelligenza artificiale ha acquisito la reputazione di appartenere a una categoria diversa. Ha un codice, il suo "algoritmo", che le permette di cercare schemi in grandi quantità di dati per essere in grado di risolvere problemi a cui noi avremmo difficoltà a rispondere. Questi algoritmi possono persino modificarsi per provare nuovi modi più efficaci di fare le cose e quindi raggiungere meglio l'obiettivo desiderato. Proprio come noi quando impariamo. Perché, anche se non in modo così efficiente, anche noi riconosciamo gli schemi nei dati e adattiamo di conseguenza il nostro approccio ai problemi. È così che progrediamo nella nostra vita. Da bambini non abbiamo un'enciclopedia incorporata. Siamo invece dotati di curiosità, di un desiderio di sapere come funziona il mondo, di recettori del piacere che ci incoraggiano a compiere azioni e di recettori del dolore che ci dicono di evitare altre cose. Abbiamo altri sensi, come il sentire e il vedere, che ci permettono di interagire con il mondo circostante. Ma a differenza del chatbot di Google, abbiamo anche un concetto di sé, la nostra senzienza. Quando il chatbot risponde alle nostre domande non fa altro che cercare indizi nella domanda che gli indichino quale parte dell'immensa quantità di dati a cui ha accesso può essere trasformata in una risposta che mi soddisfi. Che non stia valutando i dati in modo indipendente o intelligente è dimostrato dai numerosi esempi di risposte pregiudicate che produce a partire dai dati pregiudicati che cerca per dare quelle risposte. Non sembra filtrare i dati per verificare la razionalità o il pregiudizio o chiedere ulteriori informazioni o sondaggi di opinione prima di rispondere. In effetti, è ovvio che manca del tutto di giudizio nel senso umano normale. Riesce in qualche modo a "capire" la domanda o la risposta e le loro ramificazioni? Ovviamente no. Perché dovrebbe averne bisogno? Sicuramente sarebbe uno spreco di energia di elaborazione, anche se fosse possibile. Quando Deep Blue gioca a scacchi ha una qualche idea delle emozioni umane che ci spingono a competere? Capisce che la sua programmazione è in realtà parte di una ricerca da parte nostra per capire come scrivere al meglio un codice che produca ogni volta risultati migliori? Ha capito che la sua maestria negli scacchi è solo un effetto collaterale necessario per attirare l'attenzione del pubblico e ottenere così maggiori finanziamenti per il progetto AI? No? Beh, è quello che facciamo noi umani. E questa capacità di strategizzare, di vedere il quadro generale, la nostra intelligenza generale, ci distingue dalle macchine - al momento. Attualmente non stiamo cercando di creare macchine in grado di pensare come noi, ma solo macchine in grado di svolgere determinati compiti meglio di noi, senza sapere cosa stanno facendo o perché lo stanno facendo. Arriverà il giorno in cui potremo produrre macchine intelligenti con una consapevolezza del mondo che le circonda? C'è naturalmente la piccola difficoltà di non sapere come noi stessi abbiamo la senzienza, anche se alcuni di convinzione religiosa direbbero che si tratta di un'aggiunta data all'homo-sapiens dal nostro creatore. Se però crediamo semplicemente in un mondo fisico di cause ed effetti, allora non c'è motivo di pensare che la creazione di un'intelligenza autocosciente sia impossibile in linea di principio. Dopo tutto, noi esistiamo, così come gli altri animali. E più studiamo il mondo animale, più sembriamo vedere segni di senzienza che, insieme a un certo grado di intelligenza, permette loro di vivere le loro vite, spesso complesse ma relativamente limitate. Perché, però, dovremmo voler fare il passo successivo - la creazione di un'intelligenza artificiale e senziente? Lasciando da parte tutti i futuri distopici rappresentati dai film di fantascienza, sembrerebbe che non abbia molto senso creare "I Robot". Perché dovremmo creare un essere senziente, capace di sopravvivere da solo e quindi con le emozioni necessarie a motivarlo e l'intelligenza generale per capire cosa sta succedendo? Cosa ci guadagniamo? Anche la lobby della guerra si opporrebbe allo sviluppo di macchine da guerra senzienti. Potrebbero rivoltarsi contro i loro creatori e diventare pacifisti. Sicuramente dovremmo continuare a sviluppare macchine non pensanti che possano essere esperte assolute in campi ristretti in cui possono aiutare noi esseri umani a vivere meglio e in modo più sano, senza che noi dobbiamo decidere quali emozioni debbano avere, fornire loro psicologi o almeno programmi radiofonici per esprimere i loro sentimenti o anche dover fare chiacchiere con loro. I novembre 2022 Paul Buckingham |

||